“Sapere qualcosa in più non distrugge il mistero, perché la realtà è tanto più meravigliosa di quanto potesse immaginare alcun artista del passato! Perché i poeti non ne parlano?” (Richard Feynman). “Earthquake Warning!”. Tutto si gioca nella corretta Misura del Futuro, uno dei tanti possibili e immaginabili mondi cristallizzati nelle nostre vite “estratte” dalla somma sulle storie di quantistica memoria. Se i ciarlatani di fine e inizio anno, sono sempre all’opera per ingannare le menti più deboli, perché sforzarsi di immaginare l’inesistente, quando già sotto i nostri occhi, nella forma matematica delle scienze fisiche, la bizzarra fisica quantistica è il più grande sforzo intellettuale umano di sempre compiuto dalla mente per dare forma a “qualcosa” di apparentemente inspiegabile, irrappresentabile e impossibile, con il bacio dell’addio a fantasmi, violenza politica, vaticini e oroscopi? Il 2015 sarà l’ennesimo anno di fallimenti astrologici, morali, etici, sociali e politici? In Italia dal 1° Gennaio 2015 ogni famiglia pagherà mediamente 1656 euro di tasse energetiche in più, per la felicità dei Signori della guerra. Risibile, dunque, appare la riduzione del 3 percento sulla bolletta dell’elettricità e dello 0,3 percento su quella del gas della famiglia-tipo con consumi medi di energia elettrica pari a 2.700 kWh/anno con potenza impegnata di 3 kW, nel primo trimestre 2015. Per l’elettricità la spesa per la famiglia-tipo tra l’Aprile 2014 e il Marzo 2015 sarà di 513 euro, con un calo dello 0,6 percento rispetto ai 12 mesi equivalenti dell’anno precedente (Aprile 2013-Marzo 2014). Per il gas la spesa della famiglia tipo nello stesso periodo sarà di 1.143 euro, con una riduzione del 6 percento circa, corrispondente ad un “risparmio” apparente di 72 euro. Totale parziale di 1656 euro (Fonte Sole24Ore). Senza contare lo spettro dell’aumento dell’IVA (oggi al 22 percento in Italia) al 24 percento dal 1° Gennaio 2016 e i tragici effetti sull’economia italiana delle insensate sanzioni economiche imposte dai Warlords contro la Russia cristiana. Ma passiamo alla Scienza. Il “Physic World 2014 Breakthrough of the Year” è il riconoscimento che Physics World, rivista mensile dell’Institute of Physics, assegna ogni anno a quella che ritiene la maggiore notizia nel campo della Fisica. I criteri di attribuzione erano: la rilevanza della ricerca, il progresso nella conoscenza scientifica reso possibile, il rapporto tra aspetti teorici e sperimentali, e in generale l’interesse della notizia nel panorama della fisica contemporanea. “Per la Fisica questa del 2014 è stata una grande annata – dichiara Hamish Johnson, editor di Physics World – ed è stato bello avere da scegliere tra 10 lavori tutti di grande rilievo e ognuno dei quali rappresenta un grande passo avanti fatto dal team di ricercatori coinvolti”. Il vincitore del 2014 è stato l’accometaggio di Philae, modulo della sonda Rosetta, sulla cometa 67P/Churyumov-Gerasimenko. A poche settimane dal landing sono già due le scoperte interessanti effettuate dalla missione europea. La prima, annunciata appena pochi giorni dopo il touchdown, è il fatto che sulla cometa sono presenti molecole organiche. Fatto scientifico che consolida l’ipotesi di come i “mattoni della vita” possano essere arrivati sulla Terra, almeno in parte, dai corpi minori del Sistema Solare. La seconda notizia riguarda l’abbondanza di Deuterio nell’acqua della cometa 67P misurata dallo spettrometro di massa ROSINA a bordo di Rosetta. Tale abbondanza, troppo alta per essere compatibile con quella dell’acqua terrestre, rafforza l’idea che l’origine dei nostri oceani vada ricercata negli asteroidi piuttosto che nelle comete come 67P. Ma esistono molti astri chiomati ancestrali nel Sistema Solare, senza contare le esocomete aliene che vagano nello spazio interstellare. Physics World elenca le altre 9 scoperte in ordine sparso, senza stilare una vera e propria classifica. Quella sui primi neutrini solari è una ricerca condotta interamente in Italia, precisamente nei Laboratori Nazionali del Gran Sasso. L’esperimento Borexino ha compiuto la prima rivelazione diretta di neutrini prodotti dalle reazioni nucleari che alimentano il Sole. È stato poi osservato un filamento cosmico. I filamenti cosmici sono strutture che collegano gli ammassi e i superammassi di galassie, formando la cosiddetta Rete Cosmica (Cosmic Web), ma a differenza degli ammassi di galassie, gli scienziati non li avevano ancora osservati. Fino a quando Sebastiano Cantalupo, Piero Madau e Xavier Prochaska (Università della California), Fabrizio Arrigoni-Battaia e Joseph Hennawi (Istituto Max-Planck per l’Astrofisica, in Germania) hanno usato la radiazione ultravioletta emessa da un quasar lontano per osservare in maniera indiretta il gas di un filamento cosmico. Questa scoperta apre una nuova finestra di osservazione dell’Universo e avrà importanti conseguenze nello studio della formazione delle strutture cosmiche. È stata simulata una Supernova. L’Astrofisica è presente nella top ten con una ricerca condotta da Gianluca Gregori e Jena Meinecke (Università di Oxford) insieme ad altri scienziati. Il team ha creato in laboratorio l’analogo di una Supernova. Non una a caso, bensì della stella “Cassiopea A” che si distingue per la sua forma irregolare dovuta alla presenza di intensi campi magnetici, la cui spiegazione però rimaneva abbastanza misteriosa.

“Sapere qualcosa in più non distrugge il mistero, perché la realtà è tanto più meravigliosa di quanto potesse immaginare alcun artista del passato! Perché i poeti non ne parlano?” (Richard Feynman). “Earthquake Warning!”. Tutto si gioca nella corretta Misura del Futuro, uno dei tanti possibili e immaginabili mondi cristallizzati nelle nostre vite “estratte” dalla somma sulle storie di quantistica memoria. Se i ciarlatani di fine e inizio anno, sono sempre all’opera per ingannare le menti più deboli, perché sforzarsi di immaginare l’inesistente, quando già sotto i nostri occhi, nella forma matematica delle scienze fisiche, la bizzarra fisica quantistica è il più grande sforzo intellettuale umano di sempre compiuto dalla mente per dare forma a “qualcosa” di apparentemente inspiegabile, irrappresentabile e impossibile, con il bacio dell’addio a fantasmi, violenza politica, vaticini e oroscopi? Il 2015 sarà l’ennesimo anno di fallimenti astrologici, morali, etici, sociali e politici? In Italia dal 1° Gennaio 2015 ogni famiglia pagherà mediamente 1656 euro di tasse energetiche in più, per la felicità dei Signori della guerra. Risibile, dunque, appare la riduzione del 3 percento sulla bolletta dell’elettricità e dello 0,3 percento su quella del gas della famiglia-tipo con consumi medi di energia elettrica pari a 2.700 kWh/anno con potenza impegnata di 3 kW, nel primo trimestre 2015. Per l’elettricità la spesa per la famiglia-tipo tra l’Aprile 2014 e il Marzo 2015 sarà di 513 euro, con un calo dello 0,6 percento rispetto ai 12 mesi equivalenti dell’anno precedente (Aprile 2013-Marzo 2014). Per il gas la spesa della famiglia tipo nello stesso periodo sarà di 1.143 euro, con una riduzione del 6 percento circa, corrispondente ad un “risparmio” apparente di 72 euro. Totale parziale di 1656 euro (Fonte Sole24Ore). Senza contare lo spettro dell’aumento dell’IVA (oggi al 22 percento in Italia) al 24 percento dal 1° Gennaio 2016 e i tragici effetti sull’economia italiana delle insensate sanzioni economiche imposte dai Warlords contro la Russia cristiana. Ma passiamo alla Scienza. Il “Physic World 2014 Breakthrough of the Year” è il riconoscimento che Physics World, rivista mensile dell’Institute of Physics, assegna ogni anno a quella che ritiene la maggiore notizia nel campo della Fisica. I criteri di attribuzione erano: la rilevanza della ricerca, il progresso nella conoscenza scientifica reso possibile, il rapporto tra aspetti teorici e sperimentali, e in generale l’interesse della notizia nel panorama della fisica contemporanea. “Per la Fisica questa del 2014 è stata una grande annata – dichiara Hamish Johnson, editor di Physics World – ed è stato bello avere da scegliere tra 10 lavori tutti di grande rilievo e ognuno dei quali rappresenta un grande passo avanti fatto dal team di ricercatori coinvolti”. Il vincitore del 2014 è stato l’accometaggio di Philae, modulo della sonda Rosetta, sulla cometa 67P/Churyumov-Gerasimenko. A poche settimane dal landing sono già due le scoperte interessanti effettuate dalla missione europea. La prima, annunciata appena pochi giorni dopo il touchdown, è il fatto che sulla cometa sono presenti molecole organiche. Fatto scientifico che consolida l’ipotesi di come i “mattoni della vita” possano essere arrivati sulla Terra, almeno in parte, dai corpi minori del Sistema Solare. La seconda notizia riguarda l’abbondanza di Deuterio nell’acqua della cometa 67P misurata dallo spettrometro di massa ROSINA a bordo di Rosetta. Tale abbondanza, troppo alta per essere compatibile con quella dell’acqua terrestre, rafforza l’idea che l’origine dei nostri oceani vada ricercata negli asteroidi piuttosto che nelle comete come 67P. Ma esistono molti astri chiomati ancestrali nel Sistema Solare, senza contare le esocomete aliene che vagano nello spazio interstellare. Physics World elenca le altre 9 scoperte in ordine sparso, senza stilare una vera e propria classifica. Quella sui primi neutrini solari è una ricerca condotta interamente in Italia, precisamente nei Laboratori Nazionali del Gran Sasso. L’esperimento Borexino ha compiuto la prima rivelazione diretta di neutrini prodotti dalle reazioni nucleari che alimentano il Sole. È stato poi osservato un filamento cosmico. I filamenti cosmici sono strutture che collegano gli ammassi e i superammassi di galassie, formando la cosiddetta Rete Cosmica (Cosmic Web), ma a differenza degli ammassi di galassie, gli scienziati non li avevano ancora osservati. Fino a quando Sebastiano Cantalupo, Piero Madau e Xavier Prochaska (Università della California), Fabrizio Arrigoni-Battaia e Joseph Hennawi (Istituto Max-Planck per l’Astrofisica, in Germania) hanno usato la radiazione ultravioletta emessa da un quasar lontano per osservare in maniera indiretta il gas di un filamento cosmico. Questa scoperta apre una nuova finestra di osservazione dell’Universo e avrà importanti conseguenze nello studio della formazione delle strutture cosmiche. È stata simulata una Supernova. L’Astrofisica è presente nella top ten con una ricerca condotta da Gianluca Gregori e Jena Meinecke (Università di Oxford) insieme ad altri scienziati. Il team ha creato in laboratorio l’analogo di una Supernova. Non una a caso, bensì della stella “Cassiopea A” che si distingue per la sua forma irregolare dovuta alla presenza di intensi campi magnetici, la cui spiegazione però rimaneva abbastanza misteriosa.

Grazie all’uso di un laser, Gregori e colleghi hanno fatto esplodere una barra di Carbonio immersa in un gas di Argon attraversato da una griglia di plastica che aveva lo scopo di simulare le disomogeneità del materiale nei dintorni dell’astro Cassiopea A. Facendo le dovute proporzioni, l’esplosione ha creato un’onda d’urto in tutto e per tutto analoga a quella prodotta da una Supernova. Il risultato? Un campo magnetico simile a quello osservato proprio in Cassiopea A.

Il successo di questo esperimento ha fatto pensare che tale metodo di studio potrà essere usato per studiare in laboratorio molti altri fenomeni astrofisici. C’è poi la fusione nucleare “fai-da-te”. Un gruppo di ricercatori del Lawrence Livermore National Laboratory e dei Los Alamos National Laboratory, guidati da Omar Hurricane, ha condotto il primo esperimento di fusione nucleare in laboratorio in cui si sia ottenuta più energia di quanta ne fosse stata fornita precedentemente. Il team di fisici statunitensi ha acceso una piccola quantità di Deuterio e Trizio, isotopi dell’Idrogeno.

La strada è ancora lunga, ma l’esperimento segna un passo in avanti nella possibilità di produrre energia pulita infinita per uso civile tramite la fusione termonucleare che è molto più efficiente dell’attuale “fissione”. Non mancano le “compressioni quantistiche”. Siamo tutti esperti della compressione dei dati nei computer, pad e smartphone che utilizziamo quotidianamente. Ma prima dell’Anno Domini 2014 non c’era un modo per comprimere i dati nel contesto della computazione quantistica. Il primo successo l’hanno ottenuto Aephraim Steinberg e colleghi dell’Università di Toronto. Il gruppo canadese è riuscito per la prima volta a immagazzinare le informazioni quantistiche di tre fotoni in due soli fotoni. Sembra poco, ma è il primo passo per far viaggiare i dati in maniera efficace nelle prossime generazioni di computer quantistici che si alimenteranno da soli, assorbendo il calore ambientale invece che produrlo! Affascinante è la memoria degli ologrammi. Ha a che fare con la memorizzazione dei dati anche un’altro importante esperimento compiuto nel 2014, che riguarda gli ologrammi. Questi sono il risultato dell’interferenza di due raggi laser identici, di cui uno ha compiuto un percorso libero, mentre l’altro ha incontrato un oggetto. Gli ologrammi permettono di condensare l’intera informazione dell’oggetto tridimensionale su una superficie bidimensionale. In questo modo si può immagazzinare l’informazione in maniera straordinariamente efficiente. Il problema è la lunghezza d’onda della luce laser. Più è corta, meglio si riesce a campionare con precisione l’oggetto, aumentando la quantità di informazione ricavabile con questo metodo. Ma realizzare ologrammi con laser di lunghezza d’onda molto corta è veramente arduo. Alexander Khitun e altri fisici dell’Università della California sono stati i primi a realizzare l’impresa nel 2014, riuscendo a memorizzare dati usando tecniche olografiche con luce di lunghezza d’onda minore rispetto a quella visibile. Ecco le fibre ottiche “disordinate”. La luce è la protagonista di un’altra grande scoperta targata AD 2014. Grazie alle fibre ottiche e in particolare a quelle “disordinate”. Più il materiale con cui si costruiscono le fibre ottiche è disordinato, cioè disomogeneo e impuro da un punto di vista chimico, peggiore sarà la qualità delle immagini trasportate dalle fibre stesse. Ma un gruppo di fisici statunitensi guidati da Arash Mafi ha scoperto che, organizzando opportunamente il “disordine” di una fibra ottica, si possono ottenere immagini di qualità superiore a quella delle migliori fibre ottiche attualmente in commercio. La scoperta apre la via per l’applicazione della tecnica usata dal team americano per ottenere imaging di altissima qualità a scopo soprattutto medico e biologico. Per quanto riguarda la fisica fondamentale, Physics World inserisce nella sua lista un esperimento “magnetico” effettuato da Shlomi Kotler, Nitzan Akerman, Nir Navon, Yinnon Glickman e Roee Ozeri del Weizmann Institute of Science. Il gruppo israeliano è riuscito per la prima volta a misurare l’interazione magnetica tra due singoli elettroni.

Le proprietà magnetiche dell’elettrone sono note da quasi un secolo, ma il magnetismo tra due elettroni non era mai stato misurato prima, perché è estremamente debole rispetto alle altre forze che agiscono tra le due particelle, per esempio la repulsione elettrostatica. Per misurarne l’interazione magnetica occorre che i due elettroni siano molto distanti, il che però rende gli effetti magnetici ancora più modesti. I ricercatori israeliani hanno risolto il problema studiando elettroni legati a distanza tramite il fenomeno dell’entanglement quantistico. Il 2014 si chiude con una nota fantascientifica. Se i raggi traenti luminosi di Star Trek non sono ancora realtà, Christine Démoré e Mike MacDonald dell’Università britannica di Dundee ne hanno realizzato un analogo “acustico”. I due fisici hanno realizzato due particolari sorgenti di ultrasuoni. I fronti d’onda curvi prodotti da queste sorgenti interagiscono in modo tale che, incontrando un oggetto lungo il loro percorso, gli conferiscono una quantità di moto rivolta in direzione delle sorgenti stesse. Nasce la doccia sonica per le nostre pulizie? Chissà! Questa tecnica potrà trovare applicazioni soprattutto in campo medico, specialmente per trasportare opportunamente il principio attivo di un farmaco all’interno dell’organismo. Oggi nessuno mette in dubbio che, per gli abitanti del pianeta Terra, tra gli elementi e i composti chimici noti, l’acqua rappresenti il bene più prezioso per la nostra esistenza. Nonostante questa indiscussa importanza, sull’origine del prezioso elemento le idee scientifiche non sono affatto chiare. A lungo aveva tenuto banco l’ipotesi che prevedeva un’origine endogena, cioè uno scenario in cui l’acqua terrestre fosse tutto sommato quella che era dispersa nei materiali presenti nella zona in cui, quattro miliardi e mezzo di anni fa, si stava formando la Terra. Nessun bisogno di scorte successive, dunque, se non in misura davvero minima. L’obiezione più pesante a questo scenario è sempre stata quella che chiama in gioco le elevate temperature che caratterizzarono i processi di aggregazione alla base della formazione della Terra bombardata incessantemente da asteroidi e comete: vaporizzando e disperdendo il prezioso elemento, il suo accumulo nelle quantità attuali non sarebbe stato possibile. L’obiezione è indubbiamente importante. Potrebbe, però, essere elusa se si mostrassero corrette le conclusioni di un team di ricercatori del Woods Hole Oceanographic Institution pubblicate a fine Ottobre 2014 su Science. Secondo lo studio, basato sull’analisi isotopica di meteoriti provenienti dall’asteroide Vesta studiato dalla sonda Dawn, la composizione di questi materiali è molto simile a quella di alcune rocce terrestri e a quella delle condriti carbonacee, una tipologia di meteoriti ricca d’acqua. Questo ha portato i ricercatori a sostenere che l’acqua terrestre probabilmente si sia accumulata fin dai primi momenti della formazione del pianeta, assieme all’accumulo delle rocce, grazie proprio all’apporto di questi materiali. Insomma, insieme al fuoco degli impatti cosmici. La Terra, insomma, si sarebbe formata come un corpo bagnato con acqua sulla sua superficie rovente. Se, però, mettiamo in conto che, ai primordi della sua vita, il Sole era più caldo e attivo di quanto non lo sia ora, i giochi si riaprono nuovamente. Questo, infatti, sposterebbe inevitabilmente più in là la distanza limite in grado di garantire che i materiali potessero essere sufficientemente ricchi d’acqua. Avremmo insomma comunque bisogno, per il benefico rifornimento d’acqua terrestre, di dover chiamare in causa un’opportuna fonte esterna e un meccanismo sufficientemente plausibile. Con l’aumentare delle nostre conoscenze sulle tormentate fasi iniziali dell’esistenza della Terra e la scoperta non solo di un periodo d’intenso bombardamento cosmico, ma anche del suo sgradevole persistere, fortunatamente con frequenza ed energie di gran lunga inferiori, il meccanismo degli impatti poteva rappresentare una modalità estremamente plausibile per l’apporto dell’acqua sul nostro pianeta.

Tra i proiettili più gettonati per rivestire questo ruolo di “innaffiatoi” cosmici vi erano, ovviamente, le comete. La loro natura di “palle di neve sporca”, secondo il modello suggerito nel 1950 da Fred Whipple, li rendeva gli oggetti celesti ideali per quel provvidenziale rifornimento. Occorreva però verificare che i ghiacci che le componevano fossero compatibili con l’acqua dei nostri oceani. Una verifica che doveva fondarsi sulla composizione stessa del prezioso elemento, valutando cioè quali isotopi di Idrogeno fossero coinvolti. Nell’acqua terrestre, infatti, ogni 6700 atomi di Idrogeno che, uniti all’atomo di Ossigeno, compongono la molecola del prezioso elemento, si trova un atomo di Deuterio, sostanzialmente un atomo di Idrogeno il cui nucleo contiene anche un neutrone. Una firma chiara e leggibile per individuare univocamente l’acqua del nostro pianeta Terra. Sfortunatamente le osservazioni da terra dei rapporti tra Deuterio e Idrogeno nelle chiome cometarie aveva sempre dato risultati incompatibili troppo alti. Sull’affidabilità di tali osservazioni, però, vi erano grosse ombre. Osservare le chiome cometarie attraverso un’atmosfera ricca di vapore d’acqua, non è mai stato un lavoro semplicissimo. L’occasione di scavalcare il fastidioso filtro dell’atmosfera si presentò nel 1986, in occasione del ritorno della cometa di Halley. Tra le numerose sonde lanciate per l’occasione, vi era anche la nostra mitica Giotto, costruita e gestita dall’ESA e destinata ad entrare nella storia come prima missione europea nello spazio profondo. Volando nella coda della cometa, gli strumenti di Giotto appurarono che l’acqua della 1P/Halley aveva un rapporto D:H (Deuterio/Idrogeno) ben più elevato, pari ad almeno il doppio di quello dell’acqua terrestre. L’individuazione delle comete come portatrici dell’acqua sulla Terra cominciò così a vacillare. Era però solo l’inizio di una intrigante altalena di risultati che avrebbero reso sempre più enigmatica l’origine cometaria dell’acqua terrestre. Dopo la Halley, infatti, vennero prese di mira altre comete per misurarne il valore del cruciale rapporto D:H, con risultati molto contrastanti. Nel 2011 il telescopio spaziale Herschel dell’ESA osservò la cometa 103/P Hartley 2, misurando un valore di quel rapporto davvero molto simile a quello dei nostri mari. Poiché ad analoga conclusione portavano anche le osservazioni della cometa 45P/ Honda-Mrkos-Pajdušáková, l’idea del rifornimento cometario riprese forza. Cominciò altresì a diventare evidente che non si poteva fare di tutte le comete un innaffiatoio cosmico terrestre a nostro futuro uso e consumo! Era piuttosto chiaro che le comete caratterizzate, come la Halley, da un periodo orbitale maggiore e provenienti dunque dalla più esterna Nube di Oort non potevano essere chiamate in causa per l’acqua terrestre: il rapporto isotopico Deuterio/Idrogeno che le caratterizzava era troppo elevato. Molto più promettenti apparivano invece le comete provenienti dalla Fascia di Kuiper più interna del Sistema Solare. In particolare si vedevano di buon occhio le cosiddette comete della Famiglia di Giove, oggetti che, in occasione del loro passaggio nella zona planetaria, erano stati catturati dalla potente Gravità del gassoso Pianeta gigante. Dato che a questo nutrito gruppo di comete appartiene anche la 67P/Churyumov-Gerasimenko, obiettivo del recente storico attracco cometario della missione Rosetta, si attendevano con ansia i dati che la riguardavano. Nei giorni scorsi, finalmente, sono stati pubblicati su Science i risultati delle misurazioni del fatidico rapporto D:H e le carte in tavola sono state nuovamente rimescolate. I dati raccolti dallo strumento ROSINA (Rosetta Orbiter Spectrometer for Ion and Neutral Analysis) hanno infatti indicato che l’acqua della cometa 67P contiene tre volte più Deuterio di quella terrestre. Il rapporto è persino più elevato di quello che caratterizza tutte le comete provenienti dalla Nube di Oort finora esaminate. I dati pubblicati dal team coordinato da Kathrin Altwegg dell’Università di Berna, sono stati ottenuti dalle rilevazioni dello spettrometro DFMS, 50 spettri raccolti tra i primi giorni di Agosto e i primi giorni di Settembre 2014. “Questo sorprendente risultato – rivela Kathrin Altwegg – potrebbe suggerire origini differenti per le comete della Famiglia di Giove indicando che probabilmente si formarono entro un intervallo di distanze molto più ampio di quanto abbiamo finora pensato. I nostri dati, inoltre, ci portano ad escludere che tali comete contengano esclusivamente acqua come quella degli oceani terrestri, offrendo dunque più consistenza ai modelli che chiamano in causa gli asteroidi quali principali responsabili”. In tal caso, beviamo acqua cosmica asteroidale! Tali modelli vantano già a loro favore il fatto che la composizione condritrica di un gran numero di asteroidi orbitanti tra Marte e Giove li rende potenzialmente ricchi di acqua con il giusto rapporto isotopico. A questo si aggiunga che recenti sviluppi del cosiddetto Modello di Nizza, lo scenario che descrive la dinamica della formazione del nostro sistema planetario, prevedono l’importante ruolo giocato dalla migrazione dei pianeti giganti. Un colossale Ultimo Viaggio nel Sistema Solare che, come contemplato nello scenario del cosiddetto Jupiter Grand Tack (la Grande Virata di Giove), avrebbe sconvolto non la Terra di Mezzo di Bilbo Baggins, bensì la popolazione asteroidale dirottandone parte verso le regioni più esterne e parte verso le regioni più interne, Terra compresa. I meccanismi dinamici, insomma, sarebbero efficaci, come pure la corretta ricetta isotopica degli oggetti coinvolti in quel violento carosello spaziale in definitiva responsabile anche della nostra stessa esistenza. Chi si aspettava, dunque, che l’incontro ravvicinato con la cometa potesse sciogliere una volta per tutte la diatriba riguardante la fonte dell’acqua terrestre, dovrà mestamente accantonare le sue attese anche nel 2015. Anche perché, come suggerito dall’ESA, anziché chiarire i molti dubbi, Rosetta ha finito col gettare benzina sul fuoco nell’annoso dibattito sull’origine della nostra acqua. Mentre i cervelli italiani sono sempre più in fuga. Anche e soprattutto quando hanno idee vincenti. I cervelli stranieri, al contrario, non vengono in Italia. Anche quando avrebbero i soldi per pagarsi da soli le loro ricerche. L’esito della selezione dei progetti di giovani ricercatori (early-career top researchers) meritevoli di essere finanziati anche con 2 milioni di euro ciascuno, reso pubblico nei giorni scorsi dall’European Research Council, non lascia adito a dubbi o giustificazioni politiche. L’Italia ha molti bravi ricercatori e scienziati formati con i soldi pubblici delle tasse dei contribuenti. Ma questi bravi ricercatori, se possono, se ne vanno via per sempre, perché il Belpaese non offre loro l’opportunità di realizzare né i loro programmi scientifici né il loro sogno imprenditoriale tecnologico. Per la serie: “la navetta spaziale privata me la vado a costruire in Nuovo Messico o in Cina!”. Ma, al di là di ogni antifona, è sufficiente lasciar parlare i dati che sono chiarissimi. L’ERC ha selezionato 328 progetti presentati da “early-career top researchers”, dai migliori ricercatori all’inizio della loro carriera, attribuendo loro, complessivamente, 485 milioni di euro. È la settima edizione di questa iniziativa. La selezione è stata durissima. Il 90 percento delle 3.273 proposte presentate è stato scartato e solo una ristretta élite ha dunque ottenuto un ricco paniere di fiducia. Ciascuno dei vincitori spenderà il suo “grant” nell’istituzione scientifica che ha indicato, anche fuori dal Belpaese. Ebbene, nella classifica per nazionalità dei vincitori l’Italia, cioè gli Italiani, è come al solito in ottima posizione. Con 28 “grant” vinti, il Belpaese è secondo solo alla Germania, che con 68 vincitori fa la parte del leone, ed alla Francia con 36 premiati. Quasi commovente è il numero molto piccolo di vincitori britannici, appena 13. Un segnale molto positivo è che l’Italia vanta un numero di donne vincitrici decisamente alto (18). In termini assoluti le ricercatrici italiane premiate sono seconde solo alle tedesche (19). Ma in termini relativi le donne italiane sono di gran lunga le prime: il 64 percento degli Italiani premiati sono di genere femminile (18 su 28), contro il 28 percento (19 su 68) dei tedeschi. Non mancano però le dolenti note. Terza per numero di ricercatori premiati, l’Italia risulta nona per numero di ricercatori ospitati, appena 11. Preceduta nell’ordine da Germania (70 vincitori l’hanno scelta come sede delle proprie ricerche), Gran Bretagna (55), Francia (43), Olanda (34), Israele (27) e Spagna (20). Poi viene l’Italia, alla pari con Paesi molto più piccoli come Austria e Danimarca. Incredibile è la performance della Gran Bretagna, da ottava per numero di vincitori a seconda per numero di vincitori ospitati, e dell’Olanda. Anche la Spagna ospita quasi il doppio dei vincitori dell’Italia. Il confronto tra questi due insiemi di dati, la nazionalità dei ricercatori vincitori e i Paesi che li ospiteranno, è decisamente disarmante per il nostro Belpaese dei sogni di crescita e di gloria! L’Italia ha infatti il bilancio di gran luna più negativo: vanta 28 vincitori ma ospita solo 11 premiati (un delta di 17). La Germania, pur avendo un altro numero assoluto di vincitori, ha un bilancio leggermente positivo (+2), mentre la Gran Bretagna ha una capacità di attrazione davvero straordinaria perchè con appena 13 vincitori ha 55 ospiti, con un saldo molto positivo (+42). Ma anche il confronto con la capacità di attrazione degli altri Paesi, boccia l’Italia di Renzusconi ed associati. In Germania andranno 28 vincitori stranieri, in Olanda 16, in Danimarca 9, in Spagna 6. In Italia appena due! Davvero il nostro Belpaese non ha più alcun “appeal” nonostante l’Expo2015. Se poi consideriamo i vincitori che restano nel loro Paese, il quadro è ancora più netto. Restano in Germania 41 ricercatori vincitori su 68, cioè nel loro Paese, pari al 60 percento. In Spagna 14 su 19 (il 74 percento). In Francia, addirittura, 29 su 36, cioè oltre l’80 percento. Gli Italiani che invece hanno scelto l’Italia sono solo 9 su 28, appena il 32 percento. Due giovani “top researchers” Italiani su tre, insomma, vanno via, fuggono dall’Italia in crisi, evidentemente senza Futuro. L’insieme di questi dati dimostra l’assunto di partenza. L’Italia conferma di avere ottimi ricercatori, anche tra i giovani. E un numero di ottime ricercatrici, rispetto a quello di altri Paesi, risulta addirittura eccezionale. Ma queste bravi ricercatrici e questi bravi ricercatori che scelgono, probabilmente perché non hanno altra scelta, di andare all’estero per realizzare i loro progetti, sono in numero drammaticamente superiore alla normale e positiva migrazione dei cervelli di altri Paesi. Come dire che gli scienziati italiani resteranno all’estero per lavorare e formare una famiglia! Al contrario, la capacità di accogliere in Italia ricercatori dall’estero e far trovare loro un ambiente adatto, è oggi drammaticamente più bassa degli altri Paesi europei. E non vale evocare solo la contingenza economica e la bassa natalità italiana frutto di scellerate politiche contro la Famiglia naturale e la Vita (divorzio, aborto, eutanasia). La Spagna è nelle nostre stesse difficoltà economiche, ma ha numeri meno drammatici. È l’ambiente complessivo italiano, in primo luogo l’asfissiante burocrazia, la corruzione politica e la sindrome da fortezza assediata, a risultare respingente. Così il Belpaese cattolico che ha fondato la Scienza sperimentale con Galilei e le Università migliori del mondo, molte delle quali dirette da religiosi, viene bocciato dalla Storia. Il risultato è che agisce una sorta di Robin Hood al contrario: preziose risorse umane, come gli economisti definiscono le persone capaci e qualificate, vengono sottratte a un Paese relativamente povero e regalate a Paesi più ricchi. Non è questo un “spread” altrettanto significativo dell’indice finanziario il cui andamento viene giudicato decisivo per le sorti di una Nazione? Fino a quanto potremo sopportare questo continuo drenaggio di cervelli italiani in fuga? Israele vanta ben 27 vincitori, quarto Paese assoluto, uno in meno dell’Italia. Un risultato davvero significativo, frutto di una politica della ricerca molto attiva che ha portato il piccolo Stato ebraico a dotarsi di centri di ricerca di assoluta eccellenza anche con investimenti ingenti, pari quasi al 5 percento del Prodotto interno lordo! E i risultati si vedono. Tutti i 27 vincitori israeliani resteranno nel loro Paese dove trovano condizioni invidiabili. Ma nessuno straniero ha scelto un’istituzione scientifica israeliana per svolgere la sua ricerca d’avanguardia. Il Paese soffre di una certa chiusura con cui, pur dall’alto delle loro straordinarie performance, scienziati e politici israeliani dovranno confrontarsi. Come lavora la Scienza accademica? Non come la politica ricattata dagli speculatori. La “peer review” infatti lascia sempre un’impronta decisiva nella vera Scienza. Le riviste scientifiche, con i loro SI e con i loro NO determinano le sorti delle ricerche che vengono loro sottoposte ogni giorno, filtrano quello che dominerà il panorama scientifico e di cui parleranno i giornali nei mesi e negli anni successivi, e condannano all’oblio i frutti di altre ricerche giudicate non attendibili. Perché non tutto può essere pubblicato, o meglio, non tutto può venire pubblicato nelle pagine delle maggiori riviste di scienza del mondo. Funziona davvero questo metodo? La discussione nel mondo scientifico non manca di infiammare gli animi, ma secondo un nuovo studio pubblicato recentemente su PNAS pare proprio di SI. Secondo gli autori, Kyle Siler, Kirby Lee e Lisa Bero, i cosiddetti “gatekeeper”, quelli cioè che mettono in atto i meccanismi di peer review, sarebbero in grado di valutare nella maggior parte dei casi l’effettiva qualità dei lavori che vengono loro sottoposti. Fare bene però, come sostengono gli Autori, non significa certo essere perfetti. Vi sono infatti dei casi in cui articoli risultati esclusi si sono rivelati alla prova dei fatti delle scoperte scientifiche di prim’ordine o con un numero elevatissimo di citazioni, ma nonostante queste eccezioni, di norma pare che la macchina funzioni, per lo meno per la maggior parte degli studi considerati. Per permettersi quest’affermazione i ricercatori hanno interrogato un set di dati composto da 1.008 studi, 946 dei quali rifiutati e 62 accettati dalle tre riviste mediche più in vista: Annals of Internal Medicine, British Medical Journal e The Lancet. Inoltre, 757 dei 946 articoli rifiutati erano stati poi pubblicati su altre riviste con un “impact factor” minore. In particolare gli scienziati hanno esaminato quante citazioni hanno raccolto gli articoli pubblicati in una di queste tre riviste in dieci anni, dal 2003-2004, anno di pubblicazione degli articoli analizzati, fino al 2014, e quante invece quelli rifiutati e pubblicati in altre riviste. Lo scopo dello studio era di esaminare il grado di accuratezza attraverso cui gli “editor” e i “peer reviewers” prendevano le loro decisioni. È il giudizio dei “pari” a contare. Il primo aspetto emerso è che i 14 articoli più citati del “dataset” erano in realtà stati rifiutati dalle tre riviste ad alto impact factor, e 12 di questi addirittura a livello di “desk”, erano cioè stati reputati già a un primo esame di una qualità tale da non permettere loro di passare alla peer review vera e propria. Secondo gli Autori però questo fatto curioso si spiega in maniera semplice: il meccanismo dimostra delle falle quando si trova ad analizzare articoli considerati “non convenzionali”. Gli “uncommon work”, quelli che si rivelano spesso i maggiori portatori di innovazione e rivoluzione dei paradigmi scientifici sono, precisano gli Autori, particolarmente vulnerabili ad essere rigettati dalle riviste, già in una primissima fase. Questa spiegazione però sembra a tratti contrastare con un altro aspetto emerso nella ricerca e cioè che quello che importa ai “gatekeepers” è essenzialmente valorizzare la novità, purché questa sia scientificamente corroborata. E proprio la mancanza di novità è, sempre secondo quello che raccontano gli Autori dello studio, la ragione per cui i 14 articoli pluricitati sono stati in realtà rifiutati dalle tre grandi riviste e dai loro peer reviewer. “Perché anche la percezione della novità può solo essere relativa” si legge nello studio, come hanno testimoniato il Premio Nobel per la medicina Rosalyn Yalow, a cui Science rifiutò una pubblicazione, il Premio Nobel per l’economia George Akerlof e addirittura, un riferimento che si ritrova proprio nel paper, la famosa mamma di Harry Potter, J.K. Rowling. La macchina della peer review pare funzioni bene anche perché si sa correggere. Secondo i risultati ottenuti esaminando la relazione fra quando un articolo è stato pubblicato e il numero di citazioni ricevute, i ricercatori hanno notato che se un editor o un reviewer compie un errore di valutazione, nel sopravvalutare o nel sottovalutare un contributo, il sistema in realtà provvede autonomamente a dare a Cesare quello che è di Cesare. “Se uno dei tre grandi giornali rifiuta per sbaglio un articolo di valore, il lavoro in questione finisce infatti comunque per apparire in poco tempo su un’altra importante rivista. In ogni caso gli errori sono inevitabili e non esiste – precisano gli Autori – un revisore che possa garantire senza ombra di dubbio una valutazione perfetta ed efficiente. Inoltre, distinguere pessimi articoli è molto più semplice rispetto a individuare quelli davvero eccellenti”. Sebbene il sistema di revisione si sia rivelato negli ultimi anni un modo valido per determinare se un contributo è un buon articolo scientifico oppure no, si rivela in realtà meno efficiente quando si trova per le mani contributi che potrebbero rivelarsi davvero una svolta per la scienza. Insomma, “la complessità della scienza – si legge nello studio – è ancora oggi un limite per le abilità predittive anche del migliore fra i peer reviewer”. Nazione ben strana è la nostra che avrebbe già dovuto raggiungere le altre stelle ma non riesce a mettere in totale sicurezza antisismica le case degli Italiani. “Earthquake Warning!”. È illuminante il caso offerto al dott. Alessandro Amato dell’Ingv da due notizie, una pubblicata in California e l’altra in Italia.

“Parlavano quasi della stessa cosa – osserva lo scienziato – ma con approcci diametralmente opposti. Da un lato il piano di un sindaco di una città altamente sismica per la messa in sicurezza di un territorio prima del prossimo forte terremoto, dall’altro la notizia della vendita al pubblico per meno di 100 euro di un sistema di “allarme sismico” che garantirebbe ai cittadini di essere avvisati prima dell’arrivo delle onde sismiche più forti”. Riuscite a indovinare qual è la notizia italiana e quella californiana? “Il Piano del Sindaco di Los Angeles, Eric Garcetti, preparato da un team di esperti dopo un anno di lavoro – rivela Alessandro Amato – pone le basi per un significativo aumento della sicurezza dei cittadini durante e dopo un sisma, e si basa su tre azioni fondamentali: rinforzare gli edifici; irrobustire il sistema di rifornimento dell’acqua; migliorare il sistema delle telecomunicazioni. Il primo punto include l’obbligo di adeguare o demolire gli edifici che non rispettino le norme antisimiche, gli altri due riguardano le criticità maggiori individuate per Los Angeles in caso di forte terremoto”. Il Piano di Garcetti segue un’analoga iniziativa avviata nel corso degli ultimi anni dalla municipalità di San Francisco per la difesa dai terremoti. “Nell’Ottobre scorso, infatti, dopo la pubblicazione dell’elenco degli edifici che non erano stati messi a norma antisismica come veniva imposto da una legge del 1992, il direttore del Department of Building Inspection Tom Hui ha apposto un cartello di “Earthquake Warning” sugli edifici incriminati, per segnalarne a tutti la pericolosità e stimolare un comportamento virtuoso del proprietario”. Se la immagina una cosa del genere fatta da un Sindaco italiano o da un equivalente nostrano di Tom Hui, come un funzionario della Protezione Civile? “Io no, pur essendo chiaro che secondo il nostro ordinamento è proprio il Sindaco – ricorda Alessandro Amato – il primo responsabile di Protezione Civile e quindi della sicurezza dei cittadini. Il Piano di Garcetti, infatti, ha un respiro trentennale, ben oltre quello di un mandato o due da Primo Cittadino. E da noi, si sa, si fa fatica a ragionare in tempi che vanno al di là di un mandato elettorale”. Ma veniamo all’Italia. “I pochi tentativi di operare in questo senso si sono sempre infranti in resistenze, proroghe, pastoie burocratiche, interessi di categoria, e siamo ancora punto e capo (ad esempio l’OPCM n. 3274 del 2003, realizzata sull’onda emotiva del terremoto di San Giuliano del 2002 e la morte di un’intera classe di bambini, che prevedeva la verifica obbligatoria degli edifici di interesse pubblico entro cinque anni). Da qualche giorno intanto passa insistentemente in televisione la pubblicità di uno strumento stile “salva-vita”, che aiuterebbe a ridurre il rischio sismico, allertando in caso di scossa sismica. In una pubblicità accattivante si vede una coppia di persone anziane (ma non troppo, altrimenti le cose si complicherebbero un bel po’) a cui un figlio spiega al telefono il funzionamento del sistema di allerta sismico. Il sistema punta sulla sua semplicità e sul basso costo (99 euro) e si basa sul fatto che le onde più energetiche, le onde S, arrivano dopo le P. Il sistema dovrebbe venire attivato dalle P e avviserebbe quindi prima delle S. Sul sito della ditta che lo produce – osserva lo scienziato – si dice che “l’intervallo di tempo tra questi due eventi può raggiungere anche decine di secondi”, ma quel “può” fa venire più di un dubbio, come spiegato sotto. Sullo stesso sito non viene specificata una soglia di sensibilità. In un recente articolo che contiene un’intervista all’Amministratore Delegato di Guardian, Maurizio Taormina, si parla di una soglia di M3-3.2, ma non essendo specificata la distanza dal terremoto questa indicazione non ha alcun senso”. A cosa servirebbe? “La ditta che lo produce – osserva Amato – parla in modo generico di allertamento. Si sostiene che “una volta scattato l’allarme le persone hanno il tempo necessario per evacuare l’edificio o di mettersi al riparo da eventuali crolli. Si tratta di pochi attimi ma, in caso di eventi sismici, possono fare la differenza tra salvarsi o no”. Le persone che me lo hanno segnalato (amici e parenti) – prosegue Amato – dopo aver visto la pubblicità hanno tutti dichiarato che se fossero avvisati dallo strumento si precipiterebbero fuori dall’edificio. Ho dovuto loro spiegare alcuni concetti, non chiari a un non-sismologo”. E cioè? “La storia sismica italiana insegna che i terremoti causano i danni e le vittime in prossimità dell’epicentro, dove la differenza di tempo tra le S e le P è dell’ordine di un paio di secondi (altro che decine!)”. Un esempio? “Il terremoto del 6 Aprile 2009 a L’Aquila registrato al sismometro AQU dell’Ingv, ubicato in prossimità della città, nel Forte Spagnolo. L’onda S, quella più energetica, arrivò meno di 2 secondi dopo la P. Lo stesso discorso vale per le aree danneggiate dai terremoti emiliani del 2012, del Molise del 2002, dell’Umbria-Marche del 1997 e così via: danni seri entro una ventina di chilometri dall’epicentro, tempi S-P di pochissimi secondi. Nei casi come quello di L’Aquila – avverte lo scienziato – peraltro è chiaro che chi abita nell’area epicentrale di un terremoto di magnitudo 6, le onde P le avverte da solo, e non ha certo bisogno di un avvisatore. Anche per la soglia 3-3.2 di cui si parlava sopra, vale lo stesso discorso, se come probabile si intende in prossimità dell’epicentro. Provate a chiedere agli Aquilani, o agli abitanti del Modenese dove proprio poche ore fa (alle ore 8:01 del 12 Dicembre 2014) un terremoto di M3.2 è stato ben avvertito fino a oltre 30 km dall’epicentro. In caso di un terremoto più lontano (ad esempio lo stesso terremoto di L’Aquila registrato a Roma, a circa 90 km di distanza) il tempo di tragitto dell’onda P è di circa 15 secondi, quello della S di circa 26, quindi – rileva Amato – la differenza è di una decina di secondi. Ammesso che l’avvisatore si attivi all’arrivo della prima onda P a Roma, cosa farebbe la signora un po’ sorda della pubblicità alle tre di notte, svegliata (forse) dal marito o forse direttamente dal tremore? L’istinto di scappare di casa è comprensibile e difficilmente correggibile. Eppure è noto che le strutture più deboli durante un terremoto sono le scale, i balconi e i cornicioni, e ciò significa che fuggire in quella manciata di secondi espone le persone a un rischio maggiore di quello che corrono restando dentro casa. Nel terremoto di Lorca in Spagna nel 2011, di magnitudo modesta (5.1), alcune persone morirono in strada proprio per il crollo di balconi e facciate esterne, mentre le case rimasero in piedi. Per casi come questo spagnolo, e per molti altri analoghi, è sempre sconsigliato precipitarsi all’esterno di un edificio durante una scossa”. Per quanto sopra, la pratica consigliata da tutti gli istituti di sismologia e protezione civile è quella del “Drop! Cover! Hold on!”, cioè: “A terra! Copriti! Tieniti forte!”. Al professor Amato non risulta che “simili apparecchiature vengano proposte in altri Paesi sismici, e non credo sia il modo giusto né per salvare vite né per affrontare il problema del rischio sismico in Italia. Oltretutto, affidare la sicurezza a un apparecchio del genere mi pare fortemente diseducativo: potrebbe dare l’idea che con 100 euro si possa risolvere il problema, disinteressandosi della stabilità della propria casa”. In California come in Giappone, nonostante i grandi progressi fatti nella mitigazione del rischio, si ritiene ancora necessario puntare decisamente sulla riduzione della vulnerabilità degli edifici. “Ma noi Italiani – osserva Amato – siamo più furbi e aspettiamo sempre lo sciamano di turno che ci avverta del terremoto in arrivo qualche ora prima, o l’avvisatore sismico che ce lo dovrebbe segnalare addirittura in quella manciata di secondi tra l’onda P e l’onda S. E intanto continuiamo a non preoccuparci del resto. L’accostamento delle due notizie, e dei due approcci alla sicurezza dei cittadini, mi ha fatto venire in mente la sentenza del cosiddetto processo “grandi rischi”, istruito dopo il terremoto di L’Aquila per omicidio colposo nei confronti di sette esperti, accusati di avere indotto alcune vittime del sisma a non uscire dalle case la notte del 6 Aprile.

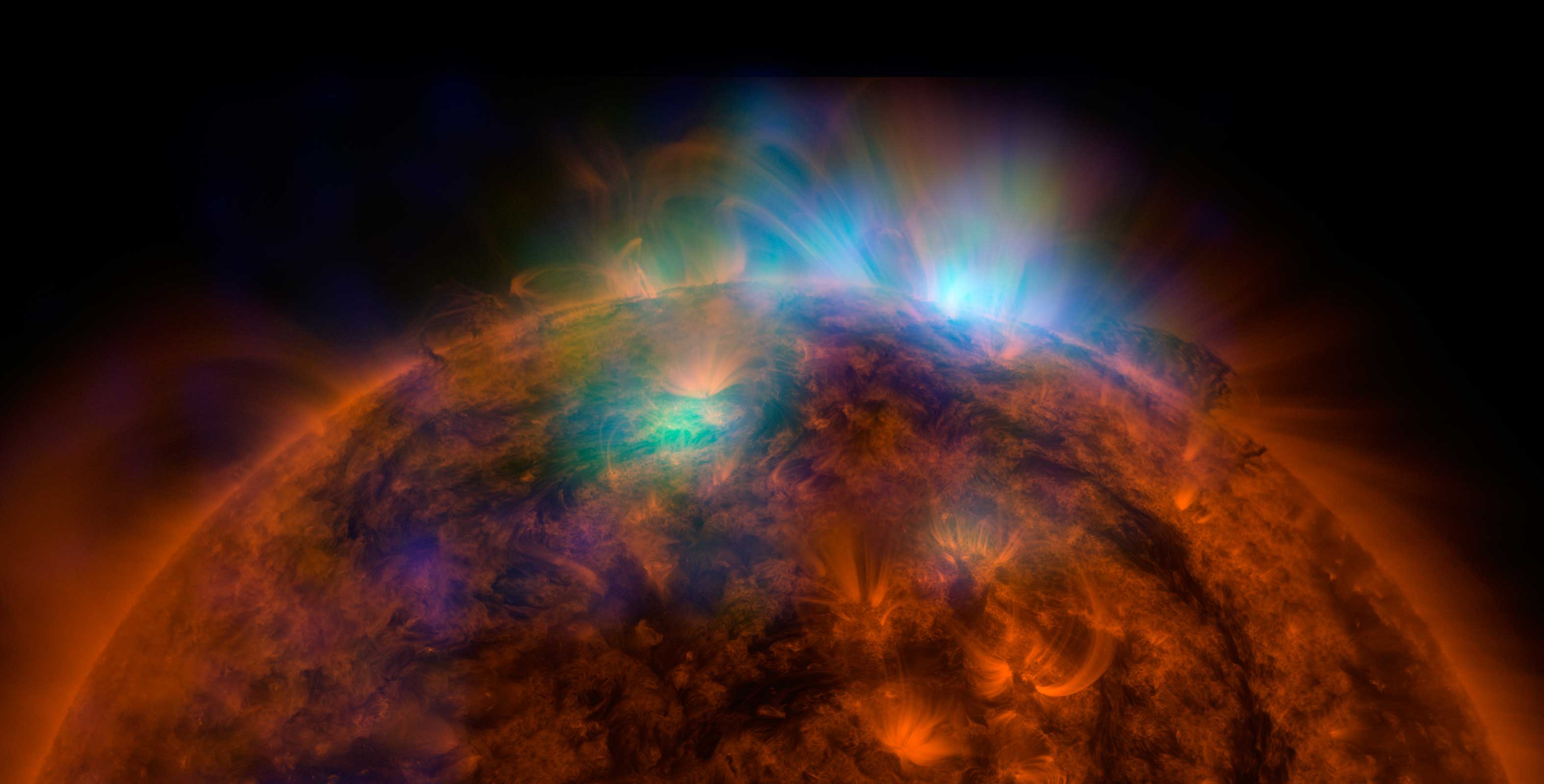

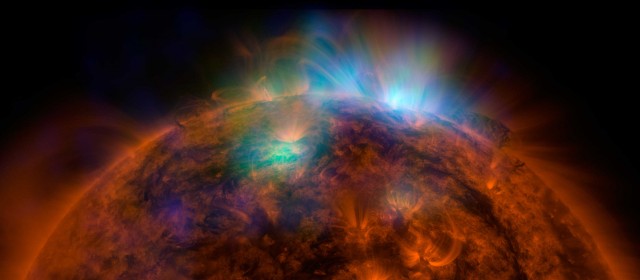

Nelle motivazioni della sentenza di primo grado, il Giudice definiva la riduzione della vulnerabilità un approccio “impraticabile” e questa necessità “tanto ovvia quanto inutile”. La sentenza Billi – ricorda lo scienziato – aveva condannato i sette esperti per omicidio colposo nei confronti di 29 persone, ma venne poi ribaltata nell’appello lo scorso mese di Novembre. La frase riportata era stata giustamente criticata da sismologi, ingegneri e giuristi nel merito e anche per il suo effetto deresponsabilizzante. Un po’ come per chi decida di affidare la propria sicurezza a una macchinetta da 100 euro”. Il Dipartimento della Protezione Civile ha inviato una segnalazione all’Autorità Garante della Concorrenza e del Mercato (AGCM) relativa alla pubblicità del dispositivo denominato “Guardian SismAlarm” affinché “verifichi la sussistenza dell’ingannevolezza del messaggio pubblicitario e, nel caso di accertamento, ne inibisca la continuazione”. Secondo il Dipartimento, infatti, nei messaggi pubblicitari diffusi nell’ultimo periodo su vari media mancherebbero “informazioni rilevanti di cui il potenziale consumatore medio avrebbe bisogno per compiere una scelta consapevole, nel momento in cui decide se acquistare o meno un prodotto commerciale di “allarme” sismico. In particolare – spiega il DPC – la pubblicità sembra indurre il consumatore a sentirsi “al sicuro” acquistando il prodotto: i messaggi veicolati sono privi dei necessari riferimenti alle caratteristiche dei forti terremoti che potrebbero colpire l’Italia, in cui il raggio di azione del fenomeno distruttivo è tipicamente limitato, con conseguenti tempistiche di allerta nulle, ovvero di pochi decimi di secondo o pochi secondi, nelle aree epicentrali in cui possono manifestarsi condizioni di pericolo per le persone. Caratteristiche del territorio italiano che non consentono di garantire con certezza che, attraverso l’acquisto di un dispositivo, in qualsiasi situazione si trovi, il consumatore abbia il tempo necessario per evacuare un edificio o comunque mettersi al riparo da eventuali crolli. Al contrario, un messaggio pubblicitario che fornisce una simile certezza secondo il Dipartimento pone il consumatore in una posizione di svantaggio e di vulnerabilità. Infine – sottolinea il Dipartimento – non va mai dimenticato che una vera mitigazione del rischio sismico può essere perseguita seriamente attraverso una matura conoscenza del territorio, una consapevolezza dei comportamenti di auto-protezione da adottare sia quotidianamente che in situazioni di emergenza, la diffusione dei piani di emergenza alla popolazione, la messa in sicurezza degli edifici”. Tempi quantistici bizzarri. “Durante l’adolescenza ero un avido lettore di una rivista intitolata The Unexplained”, rivela Jim Al-Khalili, docente di fisica teorica alla University of Surrey dove tiene anche una cattedra di comunicazione scientifica. Vicepresidente della British Science Association, è anche membro onorario della British Association for the Advancement of Science, membro della Royal Society e Ufficiale dell’Ordine dell’Impero Britannico (OBE). Nel corso della sua attività ha ricevuto il Michael Faraday Prize e il Kelvin Prize. Come comunicatore, Al-Khalili è spesso presente nei canali televisivi e radiofonici britannici, oltre a scrivere per il Guardian e l’Observer. Tra i suoi libri, “Buchi neri, wormholes e macchine del tempo” (2003). Per Bollati Boringhieri ha pubblicato “La fisica del diavolo. Maxwell, Schrödinger, Einstein e i paradossi del mondo” (2012) e “La casa della saggezza. L’epoca d’oro della scienza araba” (2013). Il suo è un ricordo, nitido, preciso, per aprire le 288 pagine del suo libro “La Fisica Dei Perplessi”, appena tradotta per Bollati Boringhieri nella collana Nuovi Saggi, in libreria con la traduzione di Laura Servidei. L’uso parsimonioso degli aggettivi “strano, bizzarro e misterioso” è indubbiamente una buona regola. Per mettere bene in chiaro che l’argomento è davvero molto interessante, Jim Al-Khalili lo dice subito, e si capisce perché. Il tema è infatti il mondo del molto piccolo dei Quanti, dove le regole del nostro mondo non valgono e, in molti casi, sono completamente rovesciate. Dopo più di un secolo, la Fisica si è ormai abituata a scendere a patti con le implicazioni della Meccanica Quantistica: questa Teoria controintuitiva si è dimostrata solidissima e perfettamente adeguata a descrivere i fenomeni della Natura, costringendo la Filosofia a un rapido aggiornamento! Ma chi, sempre a causa della Probabilità, non ha avuto in sorte l’occasione di studiare Fisica, è piuttosto perplesso come Alice nel Paese delle Meraviglie. E fa bene ad esserlo. In che senso una particella può passare da due parti contemporaneamente? Cosa vuol dire esattamente che un corpo si comporta simultaneamente come un’onda del mare e come un granello di materia? Ma davvero il gatto nella scatola è allo stesso tempo “vivo-e-morto” finché non lo guardiamo? Com’è possibile che agendo su una particella qui sulla Terra si ottenga un effetto simultaneo sulla sua gemella, che ormai naviga oltre Plutone, verso il vuoto interstellar, o ai “confini” dell’Universo, a 93 miliardi di anni luce? Sembra il mondo di Star Trek e Star Wars. Invece è il “nostro” mondo reale, benché ci siano pure il teletrasporto e la velocità di curvatura del Carlo Rubbia Warp Engine che non abbiamo ancora inventato! Questa è la materia ideale per uno straordinario divulgatore come Al-Khalili, perfettamente a suo agio con l’ironia implicita dell’argomento che racconta. Gli apparenti Paradossi della Fisica sono tantissimi. L’importante è farsi accompagnare, con brevi saggi illuminanti, da invitati d’eccezione, come Anton Zeilinger, Frank Close e Paul Davies. È normale essere perplessi di fronte a queste stranezze, ma, in fondo, la cosa più bella è farsele raccontare da chi ne sa, e finalmente capire la Verità. Per chi non pratica il genere, “The Unexplained” era una fanzine piena di avvistamenti Ufo, miti e leggende sul Triangolo delle Bermuda, fantasmi e altri fenomeni paranormali assortiti, sempre molto in voga a Capodanno. Una rivista che negli Anni Settanta del secolo scorso attraversava anche l’infanzia del sottoscritto, grazie alla famosa Barcarella abruzzese del mio carissimo nonno Giuseppe Pallini, rappresentando un tabernacolo di conferme circa la stranezza del mondo, quell’Universo pieno di cose che nessun genio, mai, finora è riuscito a capire. Il meglio di queste riviste stava nelle illustrazioni, nelle fotografie apparentemente scattate con macchine amatoriali, sfuocate, sottoesposte o più semplicemente brutte, impaginate in quadricromia a controprova di apparizioni di ectoplasmi, dischi volanti alieni e mostri di Loch Ness. “Non ho idea se la rivista venga ancora pubblicata – scrive Al-Khalili – di certo non mi è capitato di vederla recentemente, ma la fascinazione del pubblico per ogni sorta di fenomeno paranormale che sembra fuggire a una precisa e puntigliosa classificazione scientifica continua senza sosta. Sembra che molti traggano conforto dalla nozione che esistono ancora zone del nostro mondo resistenti all’inesorabile avanzata della scienza, zone dove la magia, il mistero, e la trascendenza sopravvivono e prosperano. È un peccato che sia così”. Verissimo. Specie quando Tv e giornali sottopongono le menti più deboli, con più o meno eleganza, alla solita girandola di oroscopi radiosi per il 2015, per essere sempre pronti a giurare che l’anno nuovo “sarà l’anno dei Pesci”, magari come gli ultimi dieci, o che “Saturno si opporrà” ai nostri desiderata e sa il ciarlatano cos’altro ci riservano “le stelle”! È frustrante che tutti i successi della scienza nello spiegare e razionalizzare la moltitudine di fenomeni dell’Universo siano considerati scontati, banali, atti dovuti e comunque incapaci di destare la nostra meraviglia e quella dell’economia reale. Anche il grande fisico Richard Feynman non riusciva a capacitarsi della cosa. Perché dannarsi a cercare l’incomprensibile quando è la scienza stessa a offrirci mille interrogativi su quanto ancora non riusciamo a capire o immaginare con la nostra testa? Qualcosa che ci è impossibile razionalizzare utilizzando il linguaggio di tutti i giorni esiste già. E non si tratta di quelle idee vaghe basate su concetti pseudo-scientifici come l’astrologia o le percezioni extrasensoriali. Al-Khalili pensa a una scienza propriamente detta, un campo di studio così pervasivo e fondamentale per la nostra conoscenza della Natura, che costituisce il fondamento di una parte delle scienze fisiche, la Meccanica Quantistica. Da insegnare fin da piccoli. Al-Khalili trova le parole per spiegarla accompagnando il lettore in un reame straordinario dove sembrano esserci gradi di libertà per scegliere più spiegazioni valide agli stessi fenomeni, ognuna delle quali è così sorprendente “da far sembrare i rapimenti da parte degli alieni perfettamente ragionevoli”. Razzie extraterrestri documentate dalle testimonianze dirette dei protagonisti che subiscono il delitto cosmico. Altro che “The Unexplained”. Qui l’inspiegabile è la bizzarria dei fenomeni quantistici. Un tipo di stranezza che sconvolge le nostre misere certezze e che in cent’anni di studi sulla Relatività di Einstein ha acquisito una costruzione matematica meravigliosamente accurata, utile a descrivere la Natura nei minimi dettagli, anche quelli subatomici, dall’Inizio alla Fine. Dalle origini del Cosmo ad Einstein, dall’imprevedibilità al Principio di indeterminazione di Heisenberg, dal subatomico alle teorie della Grande Unificazione. Non manca nulla nella carrellata di storie con esempi pratici per convincere anche i più scettici, compresi i politicanti. La Fisica dei Perplessi è l’incredibile mondo dei Quanti. Non ci credete? Osservate il Sole sotto un’altra luce. È stato progettato per indagare i fenomeni più violenti che avvengono nell’Universo: stelle nere, stelle di neutroni e supernovae sono alcuni dei principali obiettivi del telescopio spaziale NuSTAR della Nasa. Allora perché, oltre questi remoti oggetti, non osservare anche il nostro vicinato inrstellare? Grazie a questa semplice domanda gli scienziati del team di NuSTAR hanno deciso di puntare il telescopio in direzione della stella più vicina, il “nostro” Sole. Ed ecco lo spettacolare risultato della sua prima osservazione della corona solare. Alla ripresa del disco e della bassa atmosfera ottenuta dal Solar Dynamics Observatory (SDO) della Nasa nell’ultravioletto (in rosso-arancio) sono sovrapposte quelle di NuSTAR in verde e blu che svelano la radiazione di alta energia (in verde i raggi X tra 2 e 3 KiloElettroVolt, in blu quelli tra 3 e 5 KiloElettronVolt) emessa dal Sole. A produrla è il gas della corona riscaldato a temperature superiori ai 3 milioni di gradi Kelvin. Una ripresa mozzafiato, da copertina, dal punto di vista estetico e altrettanto emozionante per i fisici solari. La capacità che possiede NuSTAR di osservare, nelle alte energie, la corona solare può essere decisiva per catturare finalmente in azione i “nanoflare”, i mini brillamenti che sono i principali indiziati del riscaldamento della corona solare, nettamente più energetica (magnetica) della superficie del Sole. Per capirsi, qualche milione di gradi Kelvin versus i 6mila del disco. Se da una parte la nostra stella sembra voler ancora conservare gelosamente i segreti dei mini brillamenti, dall’altra è assai generosa, anche in queste ultime ore, di quelli maxi assai più potenti che potrebbero decretare un giorno la Fine del Mondo (cf. film Segnali dal Futuro). L’ultima, di classe X, la più potente esplosione solare nella scala della classificazione di questi eventi nei raggi X, è stata registrata sempre da SDO il 19 Dicembre 2014. Fortunatamente, pochi i problemi sulla Terra e grande, come sempre, lo spettacolo sui Poli, con aurore cangianti e brillantissime. Nel frattempo una nuova tappa è stata conquistata dal progetto Advanced Virgo dell’Osservatorio italo-francese EGO. Il 2014 si chiude, infatti, con l’installazione del primo specchio (beam splitter) che ha il compito di dividere il fascio laser dell’interferometro per la rivelazione delle onde gravitazionali che si trova a Cascina, nella campagna pisana. Lo specchio, con il suo sistema di sospensione e controllo, è stato collocato sul superattenuatore, il sistema di isolamento sismico del dispositivo interferometrico. La costruzione di Advanced Virgo, che ha l’obiettivo di migliorare le prestazioni del rivelatore Virgo, procede così secondo i piani. I gruppi Virgo dell’Infn sono stati protagonisti di questo complesso lavoro di integrazione. Il beam splitter di Advanced Virgo, con i suoi 55 cm di diametro, è il più grande specchio mai realizzato al mondo per un rivelatore di onde gravitazionali. “Dopo che lo scorso Giugno è iniziata la regolazione del sistema di ingresso del fascio laser (input mode cleaner), l’integrazione del beam splitter segna un altro passo significativo verso il completamento del rivelatore – spiega Giovanni Losurdo, coordinatore del progetto Advanced Virgo – l’installazione è entrata nella fase più delicata, quella dell’integrazione in situ delle componenti sviluppate nei diversi laboratori. Abbiamo appena ottenuto un successo importante, un passo cruciale nel complesso processo di costruzione del rivelatore che sarà completato entro il prossimo anno”. Fulvio Ricci, coordinatore della collaborazione Virgo, rivela che “la Collaborazione Virgo è concentrata al massimo sull’obiettivo di realizzare Advanced Virgo, e questo risultato ci rende ancora più fiduciosi che nel 2016 Advanced Virgo sarà parte del network di rivelatori di seconda generazione e inizierà la presa dati insieme alla coppia di rivelatori americani LIGO”. Con giustificato ottimismo Federico Ferrini, Direttore di EGO, osserva che “passi significativi nell’integrazione del nuovo interferometro si susseguono a ritmo sostenuto: la sfida di completare Advanced Virgo per accenderlo entro la fine del prossimo anno sarà conclusa con successo”. I successi della Fisica italiana parlano una lingua che non conosce crisi. “Alla collaborazione Borexino per essere stati i primi a rivelare i neutrini prodotti nella principale reazione nucleare che alimenta il Sole”. Con questa motivazione la rivista internazionale Physics World ha inserito nella classifica dei dieci risultati scientifici più importanti del 2014 la ricerca, pubblicata lo scorso Agosto su Nature, dall’esperimento per lo studio dei neutrini in attività ai Laboratori Nazionali del Gran Sasso dell’Infn in Abruzzo (Italia). Borexino ha realizzato la prima misura in tempo reale dell’energia della nostra stella, grazie all’osservazione dei neutrini prodotti nella reazione nucleare primaria che avviene nel cuore del Sole. Questa osservazione ha consentito di concludere che l’energia rilasciata oggi al centro della nostra stella è in perfetta corrispondenza con quella prodotta 100mila anni fa. È la prima volta nella storia dell’indagine scientifica del Sole che la sua energia è misurata nel momento stesso in cui viene prodotta. “Questo riconoscimento – rivela Gianpaolo Bellini, scienziato tra i padri di Borexino – premia l’eccellenza non solo dell’esperimento, al quale hanno dato un contributo fondamentale i gruppi di ricerca dell’Infn, ma anche quella dei Laboratori Nazionali del Gran Sasso, una grande infrastruttura con caratteristiche uniche al mondo e un centro di ricerca di prestigio nel panorama internazionale”. È anche iniziato il lungo viaggio del più grande rivelatore ad Argon liquido, il gigantesco cacciatore di neutrini ICARUS del professor Carlo Rubbia, l’esperimento “Re Sotto la Montagna” che nel 2014 ha lasciato i Laboratori del Gran Sasso alla volta del Cern (Organizzazione Europea per la Ricerca Nucleare) di Ginevra. ICARUS T600 dal 2010 ha osservato, sotto il Re degli Appennini, il fascio di neutrini in arrivo dal Cern, dopo un percorso di 730 Km attraverso la crosta terrestre. ICARUS, con un delicato trasporto per mezzo di due convogli eccezionali, è stato trasferito a Ginevra per la manutenzione e l’upgrade delle performance, in previsione di un suo probabile impiego futuro negli Stati Uniti d’America. I fisici lo considerano elemento essenziale, e attualmente insostituibile, per un esperimento con neutrini a bassa energia del Fermilab di Chicago. ICARUS è, infatti, l’unico rivelatore al mondo con più di 600 tonnellate di Argon a funzionare in modo appropriato. La tecnologia di ICARUS, proposta originariamente nel 1977 dal Premio Nobel per la Fisica Carlo Rubbia, che tutt’oggi è portavoce dell’esperimento, rappresenta così un esempio del primato italiano della Fisica Nucleare e Subnucleare (Infn) nel proporre una soluzione originale. La cui validità è stata provata dal successo dell’esperimento ai Laboratori Nazionali del Gran Sasso, che ha mostrato di ottenere una rivelazione precisa di neutrini prodotti artificialmente in acceleratori, come quelli del fascio dell’esperimento CNGS (Cern Neutrinos to Gran Sasso) in attività dal 2006 al 2012. Il dispositivo coniuga così l’originalità dell’idea italiana con la precisione e l’efficienza della realizzazione tecnica. In effetti ICARUS T600 non è un cyborg alla Terminator, bensì è un rivelatore a ionizzazione ad Argon liquido con 600 tonnellate di gas liquefatto. Il sistema di criogenia dell’impianto di purificazione dell’Argon e dell’elettronica di lettura del rivelatore, è unico e originale, ed è stato sviluppato in Italia dalle Sezioni dell’Infn. La tecnica di rilevazione permette di osservare gli eventi ionizzanti nei processi di neutrini o altri eventi rari. Il rivelatore è completamente elettronico, continuamente sensibile e si comporta come un’enorme macchina fotografica tridimensionale che visualizza gli eventi su un volume di 6 metri di larghezza, 18 di lunghezza e 4 di altezza, con la risoluzione del millimetro. Il principio di funzionamento è basato sul fatto che, nell’Argon liquido estremamente puro, gli elettroni liberati da particelle ionizzanti possono essere facilmente trasportati su distanze macroscopiche (metri) da un campo elettrico uniforme, ed essere raccolti da una struttura anodica multifilo collocata alla fine del percorso di deriva. Questa struttura è costituita da tre piani di fili distanti fra loro 3 millimetri (con fili spaziati 3 millimetri) che costituiscono quella che viene chiamata dai fisici “camera a fili”. I segnali raccolti dai circa 52mila fili, elaborati da un complesso sistema elettronico, permettono così la ricostruzione al computer dell’immagine dell’evento subnucleare. “Una delle proprietà più marcanti di questa tecnologia – osserva Carlo Rubbia – è l’estrema purezza dell’Argon liquido che permette di mantenere liberi gli elettroni prodotti, e che si misura in parti per trilione (un trilione è un uno preceduto da ben 12 zeri) equivalenti di Ossigeno residuo dell’aria da cui viene inizialmente estratto l’Argon”. La tecnologia di ICARUS e le sue prestazioni destano pertanto grande interesse nella comunità scientifica mondiale per l’impiego in futuri esperimenti sul neutrino su fasci a breve e lunga distanza, come quello al quale stanno lavorando i fisici al Fermilab di Chicago. Per questa ragione, finita l’attività nei LNGS dove ICARUS ha raccolto alcune migliaia di eventi di neutrino, è stato trasferito al Cern per la messa a punto in preparazione di nuove importanti sfide. ICARUS, una volta uscito dal tunnel del Gran Sasso, al cui interno si trovano i Laboratori Nazionali dell’INFN, ha dovuto effettuare uno stop tecnico di alcune ore in un’area si sosta dell’autostrada, per consentire i lavori di ripristino dell’assetto del tir utilizzato per il trasporto, che era stato ribassato al fine di permetterne l’uscita dal tunnel. ICARUS ha percorso tutta l’Italia, passando per Roma, Genova e quindi Torino. Infine, ha imboccato il traforo del Monte Bianco, oltrepassando così le Alpi per poi arrivare a Ginevra, nei laboratori del Cern. L’Ultimo Viaggio è durato circa una settimana. “Nei giorni precedenti il trasporto, nei Laboratori Nazionali del Gran Sasso si è lavorato per garantire che le operazioni di uscita del rivelatore di ICARUS avvenissero nella maniera più sicura e lineare possibile, nel rispetto della preziosità e delicatezza della camera – spiega Chiara Zarra, coordinatore per le operazioni di movimentazione e trasporto di ICARUS – le straordinarie misure dell’oggetto hanno dovuto fare i conti con la presenza di nuovi grandi esperimenti e con una configurazione della sala particolarmente vincolante, l’assetto dei laboratori sotterranei è infatti molto cambiato rispetto a quando ICARUS ha fatto il suo ingresso nel 2000 ed è quindi stato necessario apportare le giuste modifiche ai numerosi equipment attualmente installati e apprestare idonee misure per garantire la massima sicurezza anche degli altri apparati sperimentali presenti: il margine di manovra è stato infatti molto stretto e la tolleranza durante la traslazione era dell’ordine dei centimetri. È stato fondamentale poter contare sulla simulazione 3D effettuata dal team Cern e, di concerto con lo staff di ricercatori e tecnologi, una squadra di tecnici impiantisti e gruisti specializzati ha presieduto e vigilato sull’intera durata delle varie fasi operative: il lavoro di squadra LNGS-CERN e la cooperazione di tutti, incluse le altre collaborazioni sperimentali, hanno permesso la riuscita dell’operazione e l’inizio del Viaggio”. Avventuroso quanto quello di Bilbo Baggins. I successi dell’avventura scientifica italiana proseguono nello spazio. Il 15 Dicembre di 50 anni fa, dalle coste della Virginia, a Wallops Island (Usa), un satellite di produzione italiana inizia ad orbitare intorno alla Terra. Il nostro è stato il terzo Paese sulla Terra, dopo le grandi potenze di Urss e Usa, a inviare nello spazio un satellite. Nazione ben strana la nostra che avrebbe dovuto raggiungere già le altre stelle! Quello che viene giustamente rivendicato con orgoglio come un record che vide davanti l’Italia agli altri Paesi europei, non è tale da giustificare adeguati investimenti e continuità politico-strategica. Che pena! Eppure l’Italia ha una storia spaziale importantissima, degna di Interstellar, che inizia negli Anni ‘40 del XX Secolo con gli studi sulla propulsione portati avanti dall’Aeronautica militare di cui Luigi Broglio, il padre del progetto San Marco, così era denominato il satellite, fu parte fondamentale. Una storia fatta anche dell’appassionato appello alla condivisione europea per la ricerca e la ricerca spaziale, che ebbe in Edoardo Amaldi il suo più fervente sostenitore e portò alla creazione dell’ESRO, la European Space Research Organizzation, da cui nacque poi l’attuale Agenzia Spaziale Europea (ESA). Il progetto San Marco prevedeva anche la creazione di una base di lancio italiana, in Kenia a Malindi, con una piattaforma marittima che vide il lancio dei satelliti voluti da Broglio fino al 1988. Spediti nello spazio grazie al vettore americano Scout, in attesa che fosse realizzato il lanciatore italiano Vega. Quel Vega che ebbe la forza di diventare un programma europeo solo nel 1999 e che viene rappresentato come il successo italiano delle ultime tre ministeriali dell’Esa. Mentre i successi spaziali russi con i vettori Proton e Angara molto più appetibili nonostante le folli sanzioni economiche occidentali contro la Santa Russia (http://rt.com/news/218171-proton-astra-2g-satellite/), oggi non sono secondi ad alcuno! Il nostro, di fatto, è un Belpaese dei sogni che sembra andare avanti per strappi e transizioni gravitazionali, senza quella capacità strategica di lunga durata che auspicava Giorgio La Malfa. All’epoca valeva per il CNR, al quale faceva riferimento il Piano Spaziale Nazionale. Oggi vale per l’ASI che ne è una derivazione. Gli strappi sono rappresentati dai molti successi, da Sirio nel 1977 a Italsat F1 e F2 agli inizi degli Anni ’90, fino alla Stazione Spaziale Internazionale, vissuta con doppio ruolo, nazionale e come Paese dell’ESA, senza dimenticare il meritato riconoscimento internazionale della nostra Scuola di Astronomia delle Alte Energie, ottenuto grazie ad un progetto nazionale come BeppoSax, portato poi avanti dai telescopi AGILE, XMM e Integral con l’ESA e Swift e Fermi in bilaterale con la Nasa. E naturalmente le molte missioni interplanetarie europee (Rosetta, Mars Express, Venus Express) in trilaterale come la missione Cassini condivisa con Nasa e ESA, o in bilaterale come sulla sonda Dawn della Nasa che si sta avvicinando al pianetino Cerere. Tutto questo sforzo mette insieme scienza e capacità industriale italiana, come per l’osservazione della Terra, anche questa frutto della scuola di eccellenza italiana sostenuta in programmi ESA come ERS 1 e 2, o nazionali come SRTM e Cosmo Skymed. Tutto frutto di scelte avvenute tra la fine degli Anni ’80 e il primissimo inizio degli Anni 2000. Dopo, pare